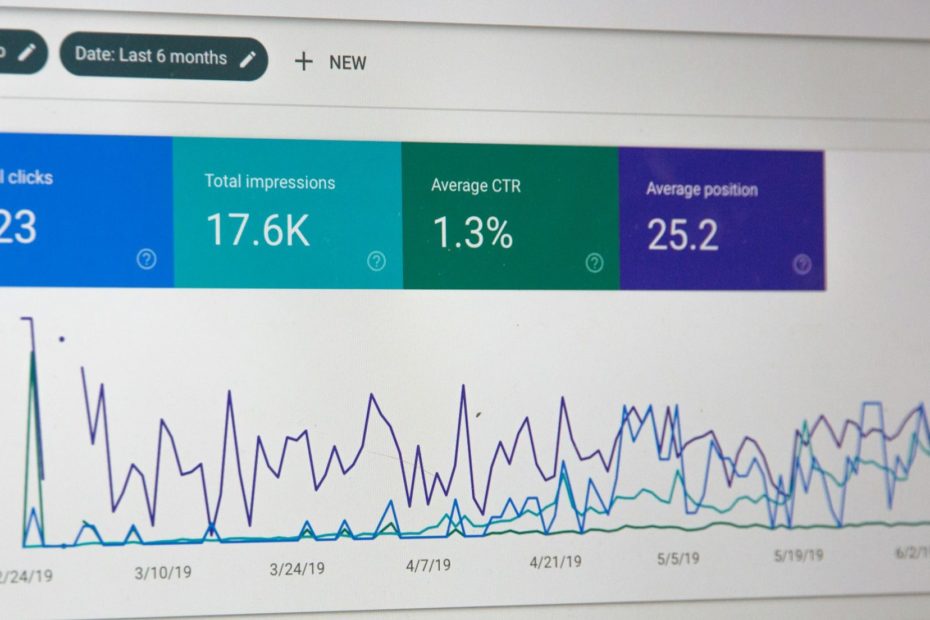

Strukturierte Daten: Der Schlüssel zu verbesserter Sichtbarkeit und Nutzererfahrung im Web

In der heutigen digitalen Landschaft ist es entscheidend, dass Websites nicht nur für Nutzer, sondern auch für Suchmaschinen optimal aufbereitet sind. Strukturierte Daten spielen dabei eine zentrale Rolle, indem sie den Inhalt einer Website in einer für Suchmaschinen verständlichen Weise darstellen.