Suchmaschinen

Die Bibliothekare des Web’s

Suchmaschinen sind unverzichtbar in der heutigen digitalen Welt und ermöglichen uns den schnellen Zugang zu Informationen in einer stetig wachsenden Datenwelt. Von den ersten einfachen Verzeichnissen der 1990er-Jahre bis hin zu modernen KI-gestützten Systemen wie Google hat sich die Technologie rasant weiterentwickelt.

Navigation

Julian Gwiasda

Was sind Suchmaschinen?

Suchmaschinen sind digitale Werkzeuge, die das Internet oder bestimmte Datenquellen durchsuchen, um relevante Informationen auf Basis von Schlüsselwörtern oder Anfragen bereitzustellen.

Wie funktioniert eine Suchmaschine?

Suchmaschinen funktionieren wie ein äußerst organisierter Bibliothekar in einer riesigen, ständig wachsenden Bibliothek. Stell dir vor, du betrittst diese Bibliothek und fragst den Bibliothekar nach einem bestimmten Thema – etwa „Regenwälder.“ Sofort weiß der Bibliothekar, wo jedes relevante Buch, jeder Artikel und jede Notiz zu diesem Thema zu finden ist. Er hat zuvor jedes Buch im Detail durchgesehen, die Themen katalogisiert und die relevantesten Stellen markiert. Anhand dieser „indizierten“ Informationen kann er dir innerhalb von Sekunden die wichtigsten Quellen nennen und sogar eine Liste in der Reihenfolge ihrer Bedeutung erstellen.

So wie der Bibliothekar Informationen über Bücher im Kopf hat, speichern Suchmaschinen Informationen aus dem gesamten Web in ihrem Index. Wenn du eine Anfrage stellst, durchsucht die Suchmaschine diesen Index, ordnet die Ergebnisse und zeigt die relevantesten Informationen an – genau wie ein Bibliothekar, der die passenden Bücher in der richtigen Reihenfolge herauszieht.

Die Geschichte der Suchmaschinen

Die Anfänge (1990er)

Die ersten Suchmaschinen entstanden in den frühen 1990er Jahren und dienten zunächst als einfache Verzeichnisse, die Webseiten sammelten und kategorisierten (Web-Katalog). Eine der ersten, Archie (1990), ermöglichte es Nutzern, Dateien auf FTP-Servern anhand von Titeln zu finden, ohne jedoch die Inhalte selbst zu durchsuchen. Kurz darauf folgten Veronica und Jughead, die ebenfalls das Durchsuchen von Dateinamen ermöglichten. Mit dem Wachstum des World Wide Web stieg die Nachfrage nach leistungsfähigeren Systemen, die vollständige Webseiteninhalte durchsuchen konnten. So entstand WebCrawler (1994) als erste Suchmaschine, die Texte im gesamten Web durchsuchte und damit eine neue Ära einleitete. Viele Suchmaschinen jener Zeit wurden noch manuell gepflegt; Yahoo beispielsweise startete 1994 als Webseitenverzeichnis und wurde schnell populär.

Die Revolution durch Google (1998)

Mit der Gründung von Google im Jahr 1998 begann eine neue Ära. Google setzte erstmals auf den sogenannten PageRank-Algorithmus, der Webseiten basierend auf der Anzahl und Qualität der auf sie verweisenden Links bewertete. Diese Herangehensweise war revolutionär und lieferte oft relevantere Ergebnisse. Die Einfachheit der Google-Benutzeroberfläche und die Genauigkeit der Suchergebnisse machten Google schnell zur dominierenden Suchmaschine.

Suchmaschinen der 2000er und Spezialisierung

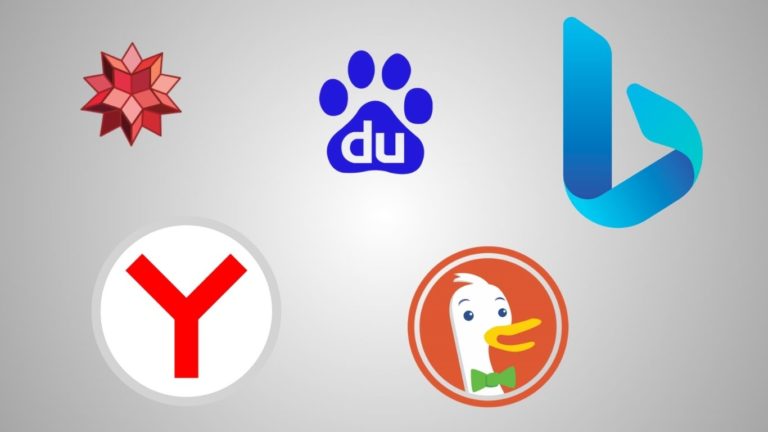

Nach Googles Erfolg entwickelten sich zahlreiche spezialisierte Suchmaschinen und Dienste. Yahoo! und Bing (Microsoft, 2009) entwickelten konkurrierende Algorithmen, die den Fokus auf Benutzererfahrung und relevante Suchergebnisse legten. Gleichzeitig entstanden Suchmaschinen wie Baidu (2000) in China und Yandex (1997) in Russland, die lokal zugeschnittene Ergebnisse lieferten und in ihren jeweiligen Märkten führend wurden.

Auch Nischen-Suchmaschinen wie DuckDuckGo (2008) und Wolfram Alpha (2009) wurden beliebt. DuckDuckGo stellte Datenschutz in den Vordergrund, indem es keine persönlichen Daten speicherte, während Wolfram Alpha eine „Antwortmaschine“ ist, die präzise, berechnete Antworten liefert.

Von Index- und Metasuchmaschinen bis hin zu semantischen und spezialisierten Lösungen

Index-Suchmaschinen

Index-Suchmaschinen wie Google und Bing durchsuchen das Web mithilfe von Crawlern und speichern Inhalte in einem Index. Sie ordnen Webseiten nach Relevanz, basierend auf Faktoren wie Keywords, Links und Aktualität. Der Index ermöglicht schnelle, schlüsselwort basierte Suchen.

Meta-Suchmaschinen

Meta-Suchmaschinen wie StartPage oder Dogpile durchsuchen andere Suchmaschinen und kombinieren deren Ergebnisse. Sie haben keinen eigenen Index, sondern greifen auf die Daten anderer Suchmaschinen zurück, um vielseitige, aggregierte Resultate bereitzustellen.

Semantische Suchmaschinen

Semantische Suchmaschinen analysieren den Kontext und die Bedeutung von Anfragen, um die Nutzer Intention zu verstehen. Mithilfe von KI und Modellen wie BERT bieten sie präzisere Antworten auf komplexe oder mehrdeutige Suchanfragen, die reine Schlüsselwörter nicht erfassen.

Spezialsuchmaschinen

Spezialsuchmaschinen konzentrieren sich auf spezifische Themengebiete, wie Wissenschaft, Reisen oder Shopping. Beispiele sind PubMed für medizinische Forschung und Google Scholar für wissenschaftliche Artikel. Sie bieten gezielte Ergebnisse und relevante Filteroptionen für bestimmte Branchen.

Die Rolle von Suchmaschinen heute

Suchmaschinen wie Google nutzen heute maschinelles Lernen und künstliche Intelligenz, um Suchanfragen besser zu verstehen und Kontexte zu erfassen. Der RankBrain-Algorithmus von Google (2015) nutzt maschinelles Lernen, um Anfragen zu interpretieren und komplexe Suchen besser zu beantworten. Zudem wurde die BERT-Technologie (2019) eingeführt, um Suchanfragen kontextbezogen zu verstehen, indem sie die Bedeutung von Wörtern im Zusammenhang analysiert.

Die Verbreitung von Voice Search (Sprachsuche) und mobilem Zugriff hat die Suchtechnologie ebenfalls beeinflusst. Viele Suchmaschinen bieten inzwischen optimierte, sofortige Antworten oder Ergebnisse für unterwegs.

Die Zukunft der Suchmaschinen

Suchmaschinen der Zukunft werden durch KI und fortschrittliche Sprachverarbeitung komplexe Anfragen präzise und kontextbasiert verstehen. Neben der klassischen Textsuche werden Sprach- und Bildsuche immer wichtiger, sodass Nutzer natürlicher und vielfältiger suchen können. Datenschutz und Anonymität rücken ebenfalls in den Fokus, da immer mehr Menschen Wert auf Privatsphäre legen. Gleichzeitig werden Suchmaschinen sich von einfachen Informationsfindern zu „Antwort- und Assistentenmaschinen“ entwickeln, die proaktiv relevante, personalisierte Informationen bereitstellen und komplexe Aufgaben direkt für den Nutzer erledigen können. KI wird dabei nicht nur Antworten liefern, sondern auch die Nutzerabsicht und den Kontext umfassend berücksichtigen.

Wichtig: Suchmaschinenoptimierung!

Suchmaschinenoptimierung (SEO) ist total wichtig, damit Webseiten in den Suchergebnissen sichtbar bleiben und mehr Nutzer erreichen. Algorithmen ändern sich ständig, deshalb braucht es aktuelle Strategien und Anpassungen. Eine SEO-Agentur weiß, wie man Webseiten technisch und inhaltlich optimiert und langfristig in den Top-Platzierungen hält. Für Unternehmen, die ihre Online-Präsenz stärken wollen, ist die Zusammenarbeit mit einer SEO-Agentur oft ein entscheidender Schritt, um nachhaltig in den Suchergebnissen sichtbar zu sein.

Unser Fazit

Suchmaschinen haben einen beeindruckenden Weg hinter sich: Von einfachen Verzeichnissen sind sie zu intelligenten, KI-gesteuerten Informationssystemen geworden. Ob Index-, Meta-, semantische oder spezialisierte Suchmaschinen – jede Art bietet Nutzern gezielte Vorteile. Künftig werden Suchmaschinen noch besser darin, unsere Absichten zu verstehen, und mit personalisierten, kontextbezogenen Ergebnissen aufwarten. KI und Sprachverarbeitung werden Suchanfragen natürlicher und präziser machen, während Datenschutz immer wichtiger wird. Die Zukunft verspricht intelligente „Antwortmaschinen,“ die weit mehr sind als reine Suchtools.

Weitere Artikel

Für SEO & SEA

Ihr Ansprechpartner

Beyond Media hilft Ihnen dabei, sich von der Konkurrenz abzuheben und bringt Ihre Website mit den richtigen SEO- & SEA-Maßnahmen nach vorne. Gewinnen Sie mit unserer Hilfe und unserer Expertise neue Kunden und sichern Sie sich und Ihrem Unternehmen langfristige und nachhaltige Erfolge mit einem starken digitalen Auftritt!